Robots.txt & llms.txt: Was ist das & Nutzen?

Die robots.txt ist ein essenzielles Werkzeug, denn sie teilt Suchmaschinen-Crawlern wie dem Googlebot mit, welche Bereiche deiner Website sie indexieren dürfen und welche nicht. In diesem Artikel erfährst du nicht nur, wie du eine robots.txt erstellst, sondern auch, welche Anweisungen sie enthalten sollte und wie du sie für SEO optimierst. Dadurch kannst du z. B. veraltete Inhalte oder nicht mehr relevante Seiten wie alte Sprachversionen aus dem Google-Index entfernen, damit deine Website sauber und effizient bleibt. Zusätzlich werfen wir einen Blick auf die neue llms.txt, die speziell für KI-Modelle entwickelt wurde und die Zusammenarbeit zwischen Websites und KI-Systemen verbessert, weil sie KI-Crawlern hilft, relevante Inhalte schneller zu erkennen.

Was ist die robots.txt?

Die robots.txt ist eine einfache, aber wichtige Textdatei, die im Stammverzeichnis einer Website abgelegt wird. Sie dient dazu, Suchmaschinen-Crawlern wie dem Googlebot mitzuteilen, welche Bereiche einer Website sie besuchen und indexieren dürfen und welche sie ignorieren sollen. Während die robots.txt also den Zugriff von Crawlern steuert, kann sie gleichzeitig helfen, das sogenannte Crawl-Budget effizienter zu nutzen. Denn Suchmaschinen haben nur begrenzte Ressourcen, um eine Website zu durchsuchen, weshalb es sinnvoll ist, sie auf die wirklich relevanten Inhalte zu lenken.

Wofür wird die robots.txt genutzt?

Mit der robots.txt lassen sich unnötige Crawl-Vorgänge verhindern, das Crawl-Budget effizienter nutzen und doppelte Inhalte oder veraltete Seiten aus dem Suchmaschinenindex fernhalten. Damit schützt sie beispielsweise Admin-Bereiche vor dem öffentlichen Zugriff und sorgt dafür, dass Suchmaschinen sich auf die wichtigen Seiten konzentrieren.

Warum ist sie wichtig?

Unnötiges Crawlen verhindern

Sie schützt sensible Bereiche wie Admin-Seiten oder temporäre Inhalte.Crawl-Budget optimieren

Suchmaschinen haben ein begrenztes Crawl-Budget, deshalb sollten sie auf die wichtigen Seiten gelenkt werden.Duplicate Content vermeiden

Sie hält doppelte Inhalte (z. B. Parameter-URLs) aus dem Index fern.Veraltete Seiten ausschließen

Sie entfernt nicht mehr relevante Bereiche, wie z. B. alte Sprachversionen, aus dem Crawling.

Wie erstellt man eine robots.txt?

Um eine robots.txt zu erstellen, genügt nicht nur ein einfacher Texteditor, sondern du kannst auch jeden beliebigen Editor verwenden. Sobald du die gewünschten Anweisungen verfasst hast, musst du die Datei als „robots.txt“ speichern und sie anschließend ins Stammverzeichnis deiner Website hochladen. Dort ist sie für alle Crawler unter der Adresse „deinedomain.de/robots.txt“ abrufbar und kann ihre Funktion erfüllen.

So gehst du vor:

- Öffne einen Texteditor (z. B. Notepad++, VS Code).

- Schreibe dann die gewünschten Regeln in die Datei (Beispiele für Anweisungen findest du weiter unten).

- Speichere die Datei als „robots.txt“, denn nur dieser Dateiname wird von Crawlern erkannt.

- Lade die Datei per FTP oder über den File Manager deines Hosting-Providers hoch, damit sie im Stammverzeichnis deiner Website verfügbar ist.

Wichtige Anweisungen in der robots.txt

Die Datei enthält Befehle wie „User-agent“ (für welchen Crawler die Regel gilt), „Disallow“ (Verbot für bestimmte Pfade) und „Allow“ (Ausnahme innerhalb einer Sperre). Auch der Verweis auf die XML-Sitemap ist möglich. Wildcards wie „*“ oder „$“ ermöglichen flexible Regeln, etwa das Blockieren aller PDF-Dateien.

Hier sind die gängigsten Befehle:

User-agent

Definiert, für welchen Crawler die Regeln gelten.

Beispiel:

User-agent: *

(* = alle Crawler)

Disallow

Verbietet das Crawlen bestimmter Bereiche.

Disallow: /admin/

Allow

Erlaubt das Crawlen in ansonsten gesperrten Bereichen.

Allow: /blog/

Sitemap

Zeigt die URL deiner XML-Sitemap.

Sitemap: https://deinedomain.de/sitemap.xml

Wildcard

Platzhalter wie * oder $ für flexible Regeln.

Disallow: /private/* # Blockiert alles unter /private/

Disallow: /*.pdf$ # Blockiert alle PDFs

Hinweis: Die Noindex-Anweisung gehört nicht in die robots.txt, da Google sie ignoriert. Nutze dafür Meta-Tags auf den Seiten.

Template für eine robots.txt

Ein typisches Beispiel zeigt, wie man den Zugriff auf das Admin-Verzeichnis sperrt, aber gleichzeitig den Zugriff auf eine bestimmte Datei darin erlaubt. Die Anweisung *„User-agent: “ gilt dabei für alle Crawler, während „Disallow: /wp-admin/“ das gesamte Verzeichnis blockiert. Allerdings schafft „Allow: /wp-admin/admin-ajax.php“ eine Ausnahme, damit diese Datei trotzdem erreichbar bleibt. Zusätzlich wird die Sitemap separat mit „Sitemap: https://deinedomain.de/sitemap.xml“ angegeben, um Suchmaschinen den Zugriff auf die Struktur der Website zu erleichtern.

Ein einfaches Beispiel für eine robots.txt:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-login.php

Allow: /wp-admin/admin-ajax.php

Sitemap: https://deinedomain.de/sitemap.xml

Beispiel: Alte Sprachversionen ausschließen

Angenommen, deine Website ist nur noch auf Deutsch verfügbar, und du hast das WPML-Plugin entfernt. Google hat jedoch alte URLs wie https://besirious.net/es/ indexiert. Mit der robots.txt kannst du diese ausschließen:

User-agent: *

Disallow: /es/*

Disallow: /fr/*

Disallow: /it/*

Sitemap: https://besirious.net/sitemap.xml

Durch diese Anweisungen wird Google sowie anderen Suchmaschinen signalisiert, dass diese Verzeichnisse nicht mehr gecrawlt werden sollen, weshalb sie schließlich aus dem Index verschwinden.

Allerdings ist wichtig zu beachten, dass die robots.txt kein sicheres Mittel darstellt, um Inhalte zu verbergen, denn sie kann von Crawlern ignoriert werden. Stattdessen sind für das vollständige Entfernen aus dem Index Meta-Tags wie „noindex“ nötig. Zudem lässt sich die Korrektheit der Datei mit Tools wie dem Google Search Console Tester überprüfen, damit man sicherstellen kann, dass sie fehlerfrei funktioniert.

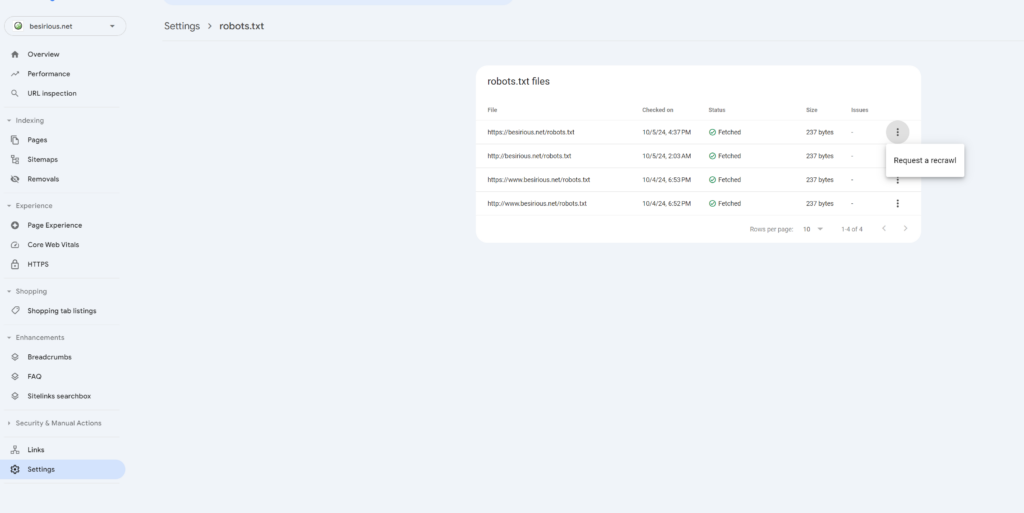

robots.txt validieren

Nachdem du deine robots.txt-Datei erstellt hast, solltest du sie unbedingt überprüfen, damit du sicherstellen kannst, dass sie nicht nur korrekt formatiert ist, sondern auch einwandfrei funktioniert. Dazu kannst du beispielsweise Tools wie den Google Search Console robots.txt-Tester verwenden, denn dieser hilft dir, mögliche Fehler zu erkennen und zu beheben.

llms.txt: Die Schatzkarte für KI-Modelle

Während sich die robots.txt ausschließlich an Suchmaschinen-Crawler richtet, wurde die llms.txt dagegen speziell für Large Language Models (LLMs) wie ChatGPT oder Gemini entwickelt. Denn sie dient nicht nur als eine Art „Schatzkarte“, sondern hilft KI-Modellen auch, die wichtigsten und relevantesten Inhalte einer Website schneller zu finden und zu verstehen, damit sie präzisere Antworten generieren können.

Was ist die llms.txt?

Die llms.txt unterstützt LLMs dabei, relevante Inhalte effizienter zu finden und zu nutzen, weil sie die Lücke zwischen komplexen HTML-Seiten und den präzisen Informationen schließt, die KI-Modelle tatsächlich benötigen. Auf diese Weise können KI-Systeme nicht nur besser verstehen, was auf einer Website angeboten wird, sondern auch gezielter auf Nutzeranfragen reagieren. Obwohl sie noch ein relativ neues Werkzeug ist, kann sie bereits einen deutlichen Unterschied machen, wenn es darum geht, dass KI-Modelle genauere und kontextbezogenere Antworten liefern.

Merkmale

- Speicherort: Stammverzeichnis (z. B. https://deinedomain.de/llms.txt).

- Format: Markdown, für Mensch und Maschine lesbar.

- Struktur:

- H1: Name der Website (Pflicht).

- > Kurze Zusammenfassung.

- Text: Kontext oder Details.

- H2: Wichtige Ressourcen als [Titel](URL): Beschreibung.

- Optional: Sekundäre Links.

# Meine Website

> Eine Plattform für SEO-Tipps und KI-Entwicklungen.

Erfahre mehr über Weboptimierung.

## Wichtige Inhalte

- [SEO-Guide](https://deinedomain.de/seo): Praktische SEO-Tipps.

- [KI-Tools](https://deinedomain.de/ki): Die besten KI-Ressourcen.

## Optional

- [Archiv](https://deinedomain.de/archiv): Alte Artikel.

In diesem Fall sagst du den Crawlern, dass alle Seiten unter /es/, /fr/ und /it/ (die Sprachversionen) nicht mehr gecrawlt werden sollen. Das hilft Google dabei zu verstehen, dass diese Seiten nicht mehr existieren, und sie werden aus dem Index entfernt.

Unterschiede zu robots.txt

Während die robots.txt Inhalte blockiert, setzt die llms.txt dagegen Prioritäten für bestimmte Inhalte. Dadurch können KI-Systeme präzisere und aktuellere Antworten generieren. Besonders Websites mit komplexen oder umfangreichen Inhalten profitieren von dieser Methode, denn sie verringert das Risiko, dass KI-Modelle veraltete oder irrelevante Informationen verwenden.

Stellt eine Website hochwertige Inhalte bereit, unterstützt die llms.txt dabei, dass KI-Systeme diese Inhalte bevorzugt berücksichtigen. So erhöht sie die Qualität der KI-generierten Antworten und sorgt für bessere Ergebnisse.

| Merkmal | llms.txt | robots.txt |

|---|---|---|

| Zweck | LLMs zu Inhalten führen | Crawling steuern |

| Format | Markdown | Text mit Direktiven |

| Blockiert? | Nein | Ja (via Disallow) |

| Status | Experimentell | Standard |

Die llms.txt blockiert nichts, sondern priorisiert Inhalte für KI-Modelle.

llms.txt Anwendungsfälle

Die llms.txt ist vor allem für Websites sinnvoll, die wertvollen, komplexen oder häufig von KI genutzten Content anbieten. Denn sie hilft nicht nur, die Genauigkeit, Aktualität und Relevanz von KI-Antworten zu steigern, sondern blockiert dabei auch keine Inhalte. Obwohl die Technologie noch experimentell ist, sollte man dennoch einen Blick auf ihre weitere Entwicklung werfen, damit man mögliche offizielle Unterstützung durch KI-Anbieter nicht verpasst. Falls sich die llms.txt durchsetzt, könnte sie zunehmend an Bedeutung gewinnen, weil sie KI-Systemen hilft, bessere Ergebnisse zu liefern.

Priorisierung hochwertiger Inhalte

KI-Modelle wie ChatGPT oder Gemini nutzen die llms.txt, um schnell und effizient die wichtigsten und relevantesten Inhalte einer Website zu identifizieren. Auf diese Weise können Betreiber sicherstellen, dass KI-Systeme bei Anfragen nicht auf zufällige Seiten zugreifen, sondern bevorzugt auf offizielle Dokumentationen, Leitfäden oder andere wichtige Ressourcen zurückgreifen. Dadurch wird nicht nur die Qualität der KI-Antworten verbessert, sondern es wird auch verhindert, dass veraltete oder irrelevante Informationen verwendet werden.

Verbesserung der Antwortgenauigkeit

KI-Modelle wie ChatGPT oder Gemini nutzen die llms.txt, weil sie dadurch schnell und effizient die wichtigsten und relevantesten Inhalte einer Website identifizieren können. Indem Betreiber diese Datei einsetzen, stellen sie sicher, dass KI-Systeme bei Anfragen nicht einfach auf zufällige Seiten zugreifen, sondern gezielt auf offizielle Dokumentationen, Leitfäden oder andere wichtige Ressourcen zurückgreifen.

Dadurch wird nicht nur die Qualität der KI-Antworten deutlich verbessert, sondern es wird gleichzeitig auch verhindert, dass veraltete oder irrelevante Informationen fälschlicherweise verwendet werden. Somit können Nutzer stets aktuelle und präzise Antworten erhalten, was die Glaubwürdigkeit und Nützlichkeit der KI-Systeme erheblich steigert.Steuerung der Inhaltszusammenfassung

Website-Betreiber können mit der llms.txt nicht nur beeinflussen, wie ihre Inhalte von KI-Modellen zusammengefasst oder zitiert werden, sondern auch, dass diese präzise und vollständig wiedergegeben werden. Das ist besonders nützlich für Unternehmen, die sicherstellen möchten, dass ihre Markenbotschaften, Produktinformationen oder rechtlichen Hinweise korrekt und lückenlos von KI-Systemen übermittelt werden. Denn nur so können sie garantieren, dass ihre Kommunikation einheitlich und verlässlich bleibt, wenn Nutzer oder Kunden Informationen über KI-gestützte Plattformen abrufen.

Unterstützung bei der Content-Discovery

Für große Websites, die über viele Unterseiten verfügen, wie z. B. Online-Shops, Wissensdatenbanken oder News-Portale, dient die llms.txt gleichsam als eine Art „Schatzkarte“ für KI-Modelle. Denn sie zeigt den Modellen nicht nur, wo sie aktuelle und vertrauenswürdige Inhalte finden, sondern auch, dass diese gut aufbereitet sind. Dazu gehören beispielsweise Blogartikel, Tutorials oder Support-Seiten, die für Nutzer besonders wertvoll und informativ sind.

Förderung der Barrierefreiheit für KI

Da KI-Modelle immer häufiger für die Automatisierung von Recherchen, Übersetzungen oder Zusammenfassungen genutzt werden, kann die llms.txt dabei helfen, dass auch komplexe oder technisch anspruchsvolle Inhalte – wie z. B. API-Dokumentationen oder Forschungsdaten – von KI-Systemen nicht nur besser verstanden, sondern auch effizienter verarbeitet werden. Auf diese Weise können Nutzer sicherstellen, dass KI-Systeme genauere und kontextbezogenere Ergebnisse liefern, wenn sie auf solche Inhalte zugreifen.

Experimentelle Nutzung für SEO & KI-Optimierung

Obwohl die llms.txt noch kein offizieller Standard ist, nutzen bereits einige Website-Betreiber sie, um sich frühzeitig auf zukünftige Entwicklungen vorzubereiten. Denn sie dient nicht nur als Testumgebung, sondern ermöglicht es auch, zu prüfen, wie KI-Modelle mit strukturierten Hinweisen umgehen. Darüber hinaus lässt sich dadurch feststellen, ob sich die Sichtbarkeit und Qualität der KI-generierten Ergebnisse tatsächlich verbessern lässt, wenn solche Optimierungen vorgenommen werden.

Stand 2025

Die llms.txt ist noch experimentell. Große LLM-Anbieter unterstützen sie nicht offiziell, aber sie gewinnt an Relevanz, da die Nutzung von KI wächst.

Kostenloses Tool zur Erstellung der robots.txt

Wenn du nicht sicher bist, wie du deine robots.txt erstellen kannst, gibt es unser kostenloses Tool:

FAQ

Die robots.txt ist eine Textdatei, die in das Stammverzeichnis einer Website hochgeladen wird. Sie gibt Suchmaschinen-Crawlern wie Google Anweisungen, welche Seiten oder Verzeichnisse sie crawlen dürfen und welche nicht.

Mit der robots.txt kannst du Suchmaschinen daran hindern, unnötige oder irrelevante Seiten deiner Website zu crawlen. Dies spart Crawl-Budget und hilft, den Fokus auf die wichtigen Seiten deiner Website zu legen, was die SEO-Performance verbessert.

Du kannst eine robots.txt-Datei in einem einfachen Texteditor (z. B. Notepad) erstellen. Nach dem Erstellen der Datei lädst du sie über ein FTP-Programm oder den Dateimanager deines Hosting-Providers ins Stammverzeichnis deiner Website hoch.

Die robots.txt sollte Anweisungen enthalten, wie Disallow für Bereiche, die nicht gecrawlt werden sollen, und Allow für Seiten, die explizit gecrawlt werden dürfen. Außerdem kannst du die URL deiner Sitemap angeben.

Ja, mit der Disallow-Anweisung in der robots.txt kannst du bestimmte Seiten oder ganze Verzeichnisse vom Crawling ausschließen.

Du kannst die robots.txt in der Google Search Console oder mit einem robots.txt-Tester überprüfen, um sicherzustellen, dass sie korrekt funktioniert und die gewünschten Anweisungen gibt.

Wenn du eine Seite mit der Disallow-Anweisung blockierst, wird sie von Suchmaschinen nicht gecrawlt. Das bedeutet, dass sie nicht in den Suchergebnissen erscheint oder entfernt wird, falls sie zuvor indexiert wurde.

Die llms.txt dient dazu, Large Language Models (LLMs) wie ChatGPT oder Gemini zu den wichtigsten und relevantesten Inhalten einer Website zu führen. Anders als die robots.txt, die das Crawlen steuert, priorisiert llms.txt Inhalte, um KI-Modellen zu helfen, präzise und kontextreiche Antworten zu generieren.

Die llms.txt wird im Markdown-Format erstellt, um sie für Menschen und Maschinen lesbar zu machen. Sie wird im Stammverzeichnis der Website abgelegt, erreichbar unter https://deinedomain.de/llms.txt.

Eine llms.txt enthält:

- Eine H1-Überschrift mit dem Namen der Website (Pflicht).

- Eine Blockquote mit einer kurzen Zusammenfassung.

- Textabschnitte für Kontext oder Details.

- H2-Überschriften für wichtige Ressourcen als [Titel](URL): Beschreibung.

- Einen optionalen „Optional“-Abschnitt für sekundäre Inhalte.

Beispiel: